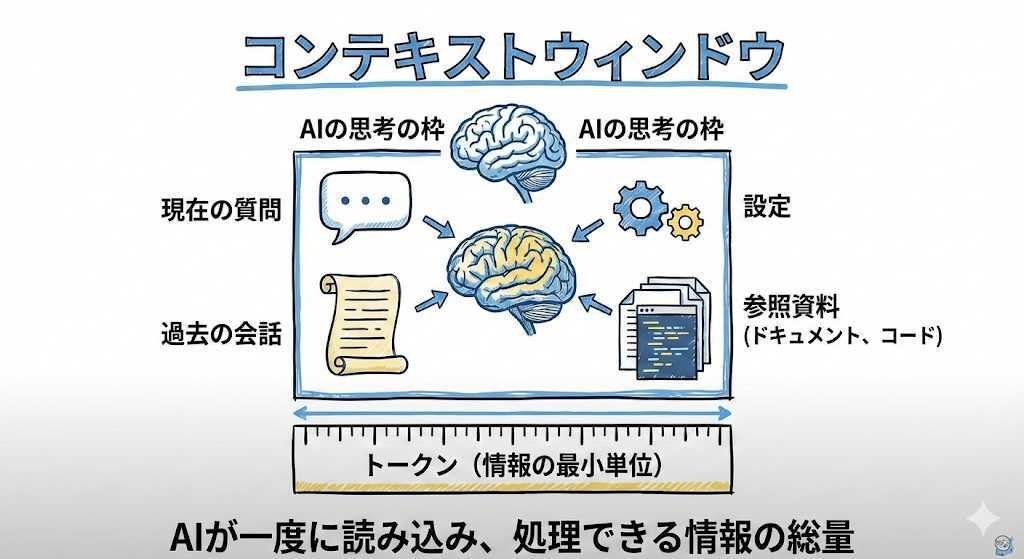

コンテキストウィンドウとは、AIがあなたの質問に対して答えを生み出すとき、一度に参照し、考慮できる情報の総量である。ただし、扱える量に限界があり、限界枠の中で直近のものだけをスライドして参照していくことから「窓(ウィンドウ)」の名がつけられた。

コンテキストウィンドウには、現在の質問や命令はもちろん、過去の会話の流れ、AIの振る舞いを決める設定、そして添付されたドキュメントやコードなどの参照資料、すべてが含まれる。この思考の枠の大きさは、「トークン」というAIが情報を数える最小単位で測られる。これは単語そのものではなく、文字や記号のまとまりのようなものである。

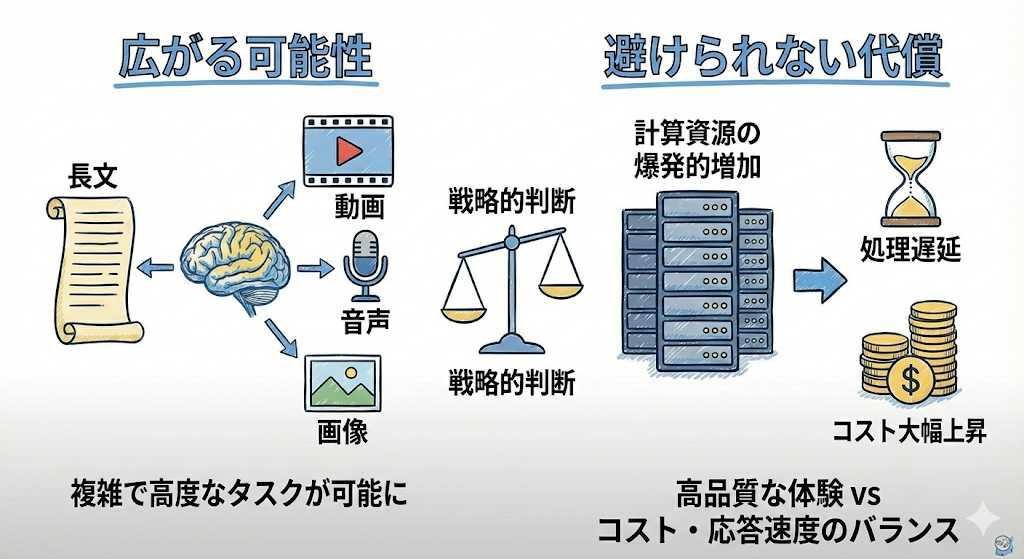

この原理は、サービス設計に決定的な影響を与える。ウィンドウが広がるほど、AIは非常に長い文章や、テキストだけでなく動画、音声、画像といった複数の種類のデータを同時に処理できるようになる。これにより、より複雑で高度なタスクをこなせるプロダクトの設計が可能になる。

コンテキストの数だけでなく、効率的な設計も必要

コンテキストウィンドウは、LLMが主流になってからその重要性が一気に高まった。初期のAIモデルが扱えた記憶量は2,000トークン程度とごくわずかだったが、2020年代に入ると、AIの仕組みや処理能力を拡大する技術が劇的に進化し、コンテキストウィンドウは急速に拡大した。たとえば、GoogleのGemini 1.5 Proモデルは現在、業界トップの200万トークン、これはテキスト約5,000ページ分に相当する情報を一度に処理できる能力を持っている。

技術が進歩して製品の可能性が広がる一方で、入力が長すぎると、AIが途中の情報を軽視してしまう「Lost-in-the-Middle」という性能上の弱点も指摘されている。そのため、最新の動向を見るとき、単にウィンドウの大きさを追い求めるだけでは不十分だ。大量の情報の中でもAIが重要な部分を見落とさず使えるように、情報を圧縮したり絞り込んだりする「コンテキスト管理の設計」こそが、優れたユーザー体験を生み出すための鍵となる。

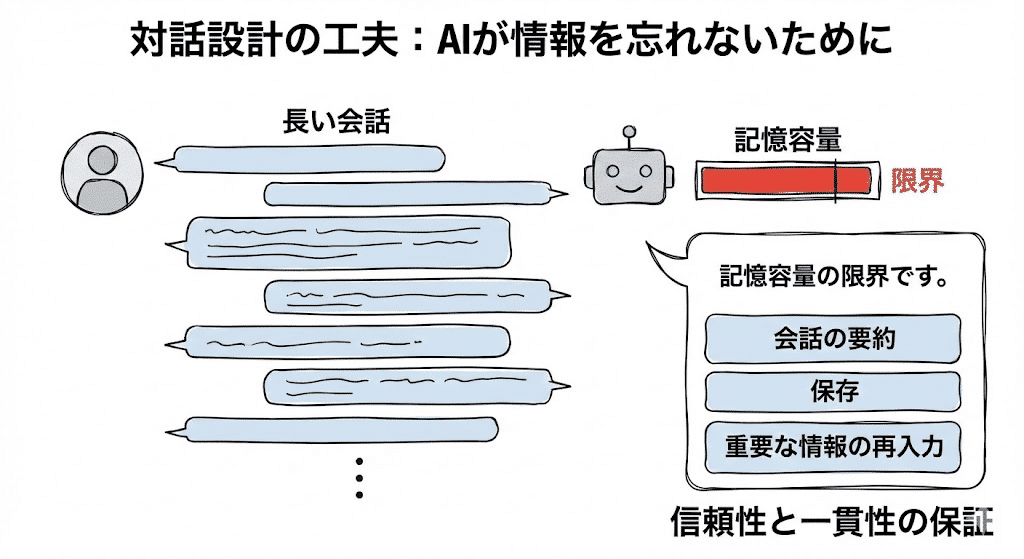

AIが情報を「忘れない」ための対話設計

会話型のAIインターフェースを設計する際に、ユーザーが何度もやり取りを続けたり複雑な作業をしたりしても、AIが会話の初期にあった重要な情報を忘れないようにするための設計が重要となる。このAIの「記憶容量」を正確に把握し、会話量が限界に近づいたときには、ユーザーに会話の要約や保存を促す選択肢を示したり、過去の情報を意識的に再入力させるような画面設計(UI/UX)を組み込む必要がある。こうした対策によって、AIが情報を忘れてしまうのを防ぎ、ユーザーとの対話の信頼性と一貫性を保証する。

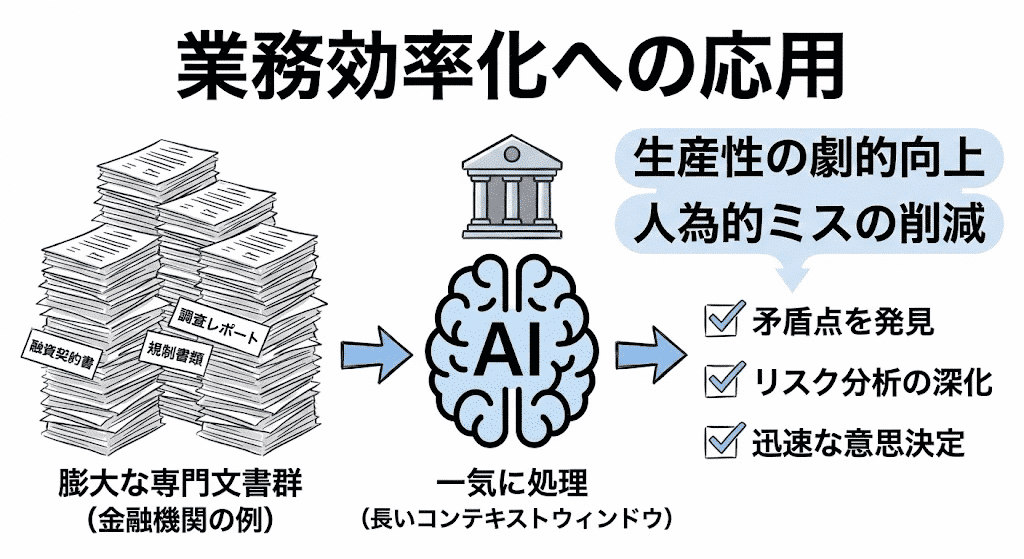

専門性の高いドキュメントを大量に読み込ませて、業務を効率化

一度に大量の情報を処理できるAI技術、いわゆる「長いコンテキストウィンドウ」の活用は、専門的な作業における「生産性の劇的な向上」と「人為的なミスの大幅な削減」に効果がある。

活用例として、金融機関における複雑な文書分析の効率化が挙げられる。例えば、ある銀行が、融資契約書、規制当局への提出書類、市場調査レポートなど、専門的で膨大な文書群を分析するために、この強力なAIモデルを導入したと想定しよう。このAIは、従来のシステムでは処理が難しかった、顧客の全財務記録や何十万語にも及ぶ法律の条文といった大量の情報を、まとめて一気に処理できる。その結果、AIは契約書の詳細な条項と最新の規制ルールとの矛盾点を素早く正確に見つけ出す。これは、融資の承認プロセスにおけるリスク分析を深め、迅速な意思決定を後押しする。