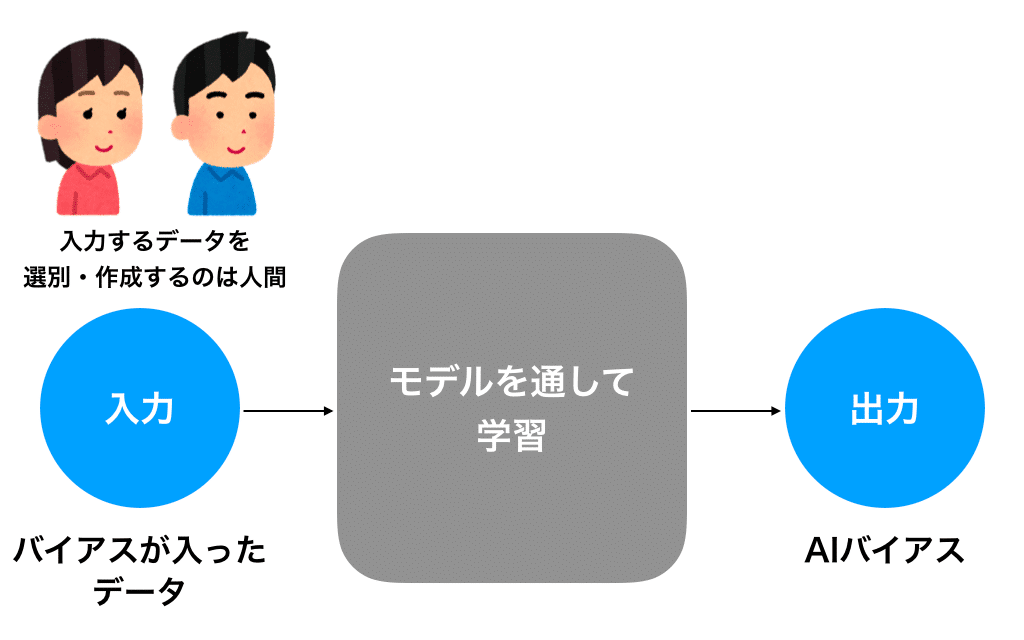

AI(Artificial Intelligence:人工知能)や機械学習で学習させるデータ自体に偏りがあると、学習するプロセスや結果の中にもバイアスが入ってしまうこと。

パターンを見つける機械学習のプロセスはブラックボックスであるため、出力された最終的な結果にバイアスがかかっているかの判断も難しい。

Amazonの人事でAIを採用

Amazonでは2014年にそれまでの10年間に渡る履歴書と採用に至った人物のデータを学習させ、効率的に履歴書の合否を判定するAIシステムを開発し運用を始めた。

その10年間で採用された人たちの中で男性の割合が多くを占めており、そのデータを学習したために、AIの判定でも男性の方が得点が高くなるという差別的な結果が出てしまった。

性別が履歴書内に記載されていなくても、名前等の要素から性別を判断して、得点を高くしてしまうこともあった。

この問題発見後、性別や関するバイアスは修正されたが、それでも様々なバイアスがかかってしまうことは避けられなかったため、AIの判定運用はとりやめられた。

人間の判断

一見公平にも思えるAIだが、Amazonの人事の例のように、学習させるデータによってバイアスがかかってしまう。

レコメンドのようなシステムであれば、各個人に合わせた結果を表示させるので問題はないが、特に医療に関わるようなセンシティブな分野は最終的には人間の判断によるチェックが必要とされることが多い。

AIも自動化された機械にすぎないので、利用する際は学習させるデータを選別することが重要で、人間次第で結果が変わるというバイアスがあることを頭に入れておく必要がある。