AIを人間の好みに合わせる学習法「RLHF」は、2つの「教師(報酬)モデル」と「生徒モデル」を用意し、主に4段階で進められる。

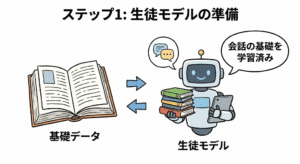

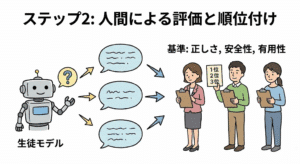

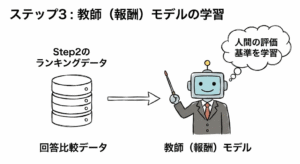

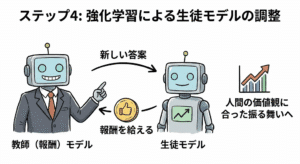

まず、会話の基礎を覚えさせた「生徒モデル」を用意する(ステップ1)。次に、生徒モデルに同じ質問を複数行い、得た回答に対して、人間が「正しさ、安全性、有用性」の基準で比較し順位付けする(ステップ2)。さまざまな質問を同じように行い、「教師(報酬)モデル」に先ほどの回答比較データを学習させる(ステップ3)。最後に、この「教師(報酬)モデル」を使い、「生徒モデル」を学習させる。生徒モデルは教師モデルの基準で一番良い回答を自ら選び、人間の価値観に合った振る舞いができるようになる(ステップ4)。

RLHF手法のステップ

- 会話の基礎を覚えさせた「生徒モデル」を用意

- 生徒モデルに同じ質問を複数行い、得た回答に対して、人間が「正しさ、安全性、有用性」の基準で比較し順位付けする

- 「教師(報酬)モデル」に2の回答比較データを学習させる

- 「教師(報酬)モデル」を使って、「生徒モデル」を学習させる

提唱者

Paul Christiano氏らを中心としたOpenAIおよびDeepMindの研究グループが、論文「Deep Reinforcement Learning from Human Preferences」の中で確立・実証した。ポール氏らは、アタリのゲームやロボットシミュレーションにおいて、人間が「どちらの動きが良いか」を比較・選択したデータから報酬関数を学習させ、それを用いてAIを訓練する手法を提案した。これが現在のLLMにおけるRLHFの基礎技術となっている。

Paul Christiano https://www.nist.gov/people/paul-christiano

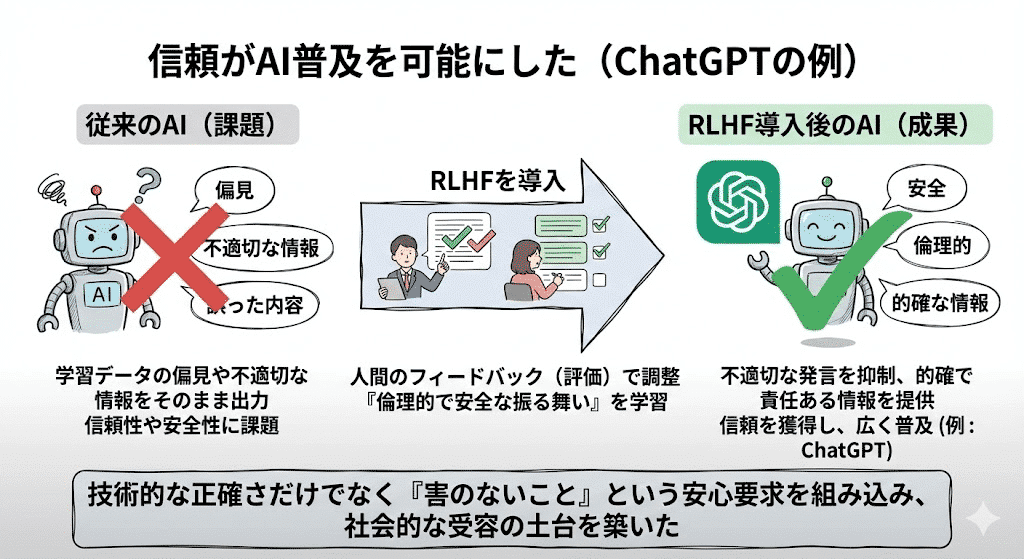

従来のAIは、学習データに含まれる偏見や不適切な情報をそのまま出力してしまうという、信頼性や安全性に関する根本的な課題を抱えていた。この問題を解決するため、OpenAI社は人間のフィードバック(評価)をAIの調整に活用するRLHFという手法を導入し、ChatGPTのような対話型AIに適用した。

信頼がAI普及を可能にした

ChatGPTがこれほど広く使われるようになった背景には、OpenAIが開発過程で徹底して行った「倫理的で安全な振る舞いの学習」がある。これが、技術的にはRLHFと呼ばれる仕組みの最も有名な成功例だ。

初期のAIモデルが有害な情報や誤った内容を生成するリスクを減らすため、OpenAIはこのRLHFという手法を導入した。具体的には、人間の評価者がAIの回答を一つ一つ確認し、「どれが一番安全で、倫理的で、ユーザーの意図に沿っているか」を順位付けして評価した。この人間による「好み」のデータを使ってAIを再訓練した結果、不適切な発言を抑制し、的確で責任ある情報を提供する、現在のChatGPTが実現した。

技術的な正確さだけでは測れない「害のないこと」という、ユーザーの根本的な安心要求をプロダクトに組み込んだことで、AIが社会的に広く受け入れられる土台を築いた。

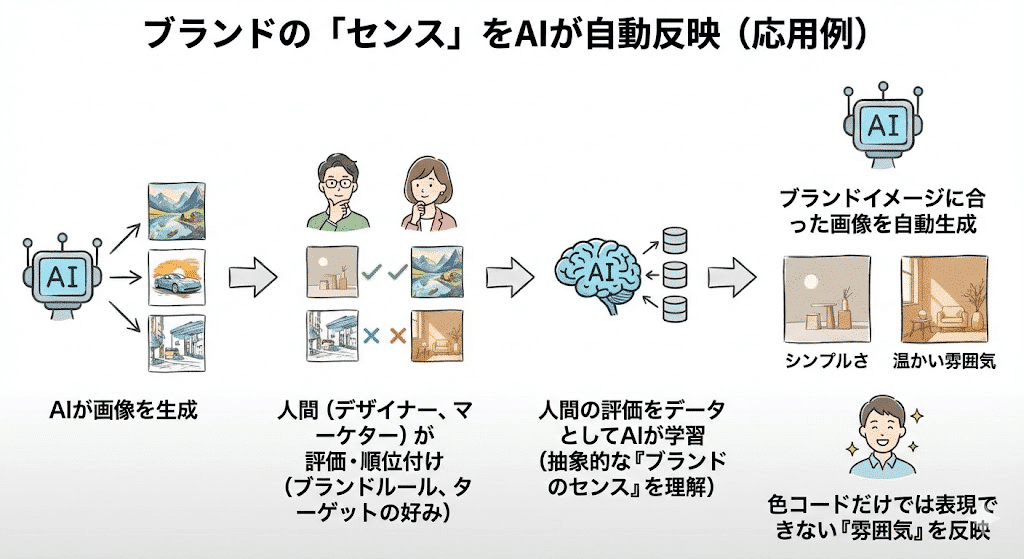

ブランドの「センス」をAIが自動反映

画像生成AIの応用例として、ブランドイメージに合う画像かどうかをAIが自動で判断する方法がある。

自社の製品に画像生成AIを使い、「シンプルさ」や「温かい雰囲気」といった特定のブランドイメージに沿った画像を顧客に提供したい場合に、この技術が使える。プロセスはこうだ。まず、AIが作った何枚かの画像を、UXデザイナーやマーケティング担当者が見て、「ブランドのルールに一番合っているのはどれか」「ターゲットの好みに最も合うのはどれか」という主観的な視点で順位をつける。この人間による評価をデータとしてAIに教え込むことで、AIモデルは、色コードのような具体的なルールだけでは表現しきれない、抽象的な「ブランドの持つセンス」を理解できるようになる。

関連用語

- 強化学習(RL)

- 教師あり微調整(SFT)

- 報酬モデル(RM)