この記事は、UX DAYS TOKYO 2017で開催された、ギルズ・コルボーン(Giles Colborne)氏の「対話型UIの設計(Designing Conversation)」講演レポートです。

UX DAYS TOKYO 2017 Colborne氏のスピーチの様子 2017/4/14開催

人にとって使いやすツールを作る

新しい技術が出る度にすぐに試してみたくなりますが、つい操作するユーザーの存在を忘れて開発を進めてしまいがちです。その結果、ユーザーが思い通りに操作出来ないなどのストレスからパソコンに向かって叫んだり、スマホを叩きつけるということが起きてしまいます。

インタラクションデザインに関わる者の役割は、技術をもっと人間的であるようにすること、つまり人にとって使いやすいツールを作ることです。

ひとつ例を出してみましょう。イギリスの時刻表は、とても複雑で分かりづらいのですが、分かりやすく使いやすくしたいとします。しかし、これを解決することは、以前よりも難しくなってきています。なぜなら、(スマホが存在する前までは、パソコンのことだけを考えれば良かったのですが)スマホの小さなスクリーンで使いやすくする必要があるからです。

ユーザーが時刻表に対して求めることは、さまざまです。例えば、一番安いチケットを取りたい、変更可能なチケットを取りたい、目的地までの時間を正確に知りたい、などです。

そのためには、大量で複雑なデータを小さなスクリーンでも把握が出来るようにしなければなりません。

それが上手くデザインされていないと、ユーザの操作にミスが起きたり、混乱を生みます。その結果、使うことを辞めて、人に質問をするようになります。将来的には、自然言語でやりとり(音声での会話・テキストチャット)するUIなっていくでしょう。例えば、質問があればボットに聞くというような感じです。

ボットがニュースを書き、読む時代

Amazon EchoやGoogle Homeでは、既に一部でそのようなUIが実用化されています。家に帰って「電気を付けて」というと電気がつく、「暖房を入れて」というとエアコンが入るなどです。次第に、ボタンをいくつも押して音楽を再生する、ということはなくなっていくでしょう。

音声UI(VUI)に慣れてくると、会話の内容がどんどんシンプルになっていきます。

「○○の音楽をかけて」

「音楽をかけて」

「再生」

というようにどんどん省略されていきます。その分、機械が賢くなっていかなければなりません。

ロイターの主要ビジネスの1つに、財務分析レポートがあります。企業のニュースに基づいて書かれていますが、最近はボットが様々な情報源からレポートを書いています。

それを人が読むのですが、実は、最近はその多くがボット化されています。ニュース(レポート)を書くのもボット、読むのもボットになっていて、その過程に人間が介在しなくなっています。

ミーティングの設定もボット化してきています。メールをボットにccで送ることで、スケジュールと照らし合わせ、各参加者に意向を確認。スケジュールを決定し、通知することも出来ます。

このような変化の中で、人にとって心地よいスムーズな会話とはどのようなものかを設計する必要が出てきます。指示を与えると応答が返ってくる会話の中で、「最小のインプット」で「最大のアウトプット」を得るのが良いインタフェースです。いくつものステップを経るのではなく、ひとつのステップですべてが解決するのが理想です。なぜなら、ステップが少なければ、ミスや誤解の可能性も減らすことが出来るからです。

ただし、Voice User Interface (以降、VUI) は公共な場では使いづらいです。機械に話しかけるのが恥ずかしい、プライベートな情報を口に出して話さなければならない(ことに抵抗感がある)などがあるからです。これらのことから、VUIは自宅や車の中でよく使われる傾向にあります。

VUIは、自宅や車の中でよく使用される

VUI(音声UI)を使う理由

VUIを使う理由は、以下のように多岐にわたっており、物理的・効率的な理由がほとんどです。

- 手がふさがっている

- タイプをするのが機器によってはやりづらい

- 話す方がタイプするより早く正確

- 台所で手が汚れているなど機械に触れづらい状態である(Amazon echoの約半数は台所に置かれている)

VUIの設計 -自然言語のインターフェース-

会話を始めるきっかけを作ることは、とても重要です。上手くきっかけを作れないと、ユーザは話しかけることができないか、過大な要求をしてしまいがちです。サービスが何をしてくれるのか?といったヒントを、まず提供する必要があります。

VUIへよく寄せられる苦情として「会話が冗長すぎる」と言う点があります。その背景には、細かい質問を繰り返すことはユーザにとって負担だという点があります。

人間同士の会話はとても簡潔です。同じようなことをボットで実現するには、ユーザーのバックグラウンドや過去の行動を共有するなど、ボットとユーザ間にある共通認識の情報を元に会話を省略する必要があります。それが出来れば、スムーズなコミュニケーションが実現されます。

例えば、最近購入したシャツを返品する際、システムが過去の注文履歴やユーザの好みを把握していると、ユーザーが「返品をしたい」と言った場合に「先週買ったあれですね?」という風にシステムが先回りして気を利かせることが出来ます。

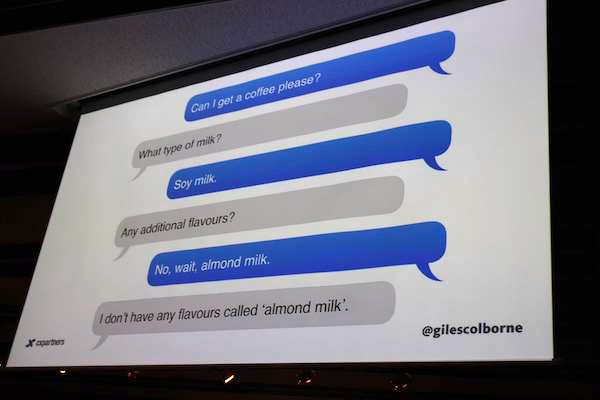

しかし、ユーザは、会話をしている間に気が変わってしまうこともあります。そうなると、ボットは会話を追いかけられなくなってしまうでしょう。

ユーザーの気は、会話の途中で変わってしまう

自然言語のインタフェースでは、次の3点がとても重要です。

- コンテキストを確立する

- ユーザの気が変わったことを察知して軌道修正する

- 簡潔なインタフェース

会話は今までのようなUIに比べて、とてもハイコンテキストなものです。小さな労力(ちょっとした言葉)で最大の結果を出すことが求められ、システムは常に学習を求められます。事実、Alexaは常に機能を追加しています。そして、そのためにオントロジー(共有されている概念化の形式的・明示的仕様)を組み込むことが鍵となっています。

VUIの設計 -ユーザーが求めるものを察知-

ユーザーが何を求めているのか、何が重要なのかを察知することが大事です。

例えば、結果をすぐに欲しい時には、詳細なナビゲーションは不要などです。この場合は、「とにかく今何をすべきか」を簡潔に提供することが正しいです。

ユーザが求めることを推測する合図を見つけ検知したり、ユーザーと共有している内容は何なのか(心の理論)を理解したりすることも設計に盛り込むべきです。

子供向けの貯金箱の例

ここで、もう少し具体的な例の話をしましょう。ある子供向けの貯金箱の話です。

その貯金箱は、物理的なコインを入れるほかに、電子的な貯金も可能です。そして、貯金箱を振るとコインが入っているようなデジタル音が鳴ります。

これらの仕様は、子供と貯金について会話するためのインタフェースです。この貯金箱を通して、子供に「何のために貯金をしたい?」と聞いた時、色々な答えを聞き出せる可能性が生まれます。

インターフェイス次第で、何のために貯金したいかを聞き出すこともできる

英語でVUIを使う時、文章の最後が聞き取れないなどのミスが起きやすいです。その際、コンテクストが共有されていないと会話をある程度巻き戻して、途中からやり直す必要があります。

また、システム側が「今、なんて言いました?もう一回お願いします。」と聞き返してきます。これだと、いかにも機械と会話しているという印象を与えてしまいます。

コンテクストが共有されていれば、推測することができ、聞き取れなかった部分だけ再度質問すると言ったことが可能です。例えば、「何のためですか?凧(kite)?バイク(bike)?」といった感じです。このようにした方が、ユーザーの負担が少ないです。

“会話”だけがインターフェイスではない

結果として同じことであっても、少しでも言い方を変えるだけで、インタラクションが生きてきて、人格を持っていると感じられるものです。返事の言葉として用いられるYesやAcceptを、親密な間柄で使うYapやOKに変えるだけでも違います。

返答の言葉を変えるだけでも、人格は生まれる

家庭用ロボットのKuriは、実際の会話は行わずに可愛らしいビープ音でコミュニケーションを取っており、完璧に人間へ近づけようとはしていません。でも、不思議と会話をしているような気分になるのです。

Google HomeやSiri、Amazon Alexaは、賢くて格好良いです。しかし、賢くなりすぎているとも言えるかもしれません。Kuriのような控えめな会話(インタフェース)が良いこともあります。

人間同士の会話では、会話の内容以外(ボディーランゲージ、声色、表情、イントネーションなど)にもヒントがあります。そこには、テキストでは表現出来ない内容が含まれています。ボットからのフィードバックも、必ずしも音声だけとは限りません。簡単なLEDアニメーションなどでも合図を送るが出来ます。絵文字など利用も有用かもしれません。

※Mayfield Robotics社のロボットKuri:Kuri Home Robot: insanely cute with some serious technology

ボットには謙虚さも必要

ユーザーにボットが必要でない時もあります。例えば、ユーザの作業を割り込むなどをしてしまうと、ボットがユーザをイライラさせることになりかねません。例えば、MS Officeのclippy(日本で言えば“カイル”というイルカ)などです。

他にも、メールを書いている最中に、Toの追加を提案をする機能があったとします。この機能が動作として正確であっても、余計なお世話である可能が高いのです。

また、Eコマースの例としてよくあるのが、レコメンデーション機能です。女性用のナプキンを買った人にワインを勧めたりします。確かに、一緒に買った人が多いのかもしれません。しかし、その相関には因果関係がありません。

もし、娘を亡くした1年後、Facebookが「1年前を振り返って祝いましょう」と提示してきたとしましょう。その提示は、悲しさを増幅させてしまうだけです。このようにアルゴリズムは、残酷に作用することがあります。

エチケットを持ったボットインタラクションを設計することは、とても重要です。一方で、Facebookは自殺志願者を推測し、思いとどまらせることも出来ています。

スタンフォード大学のClifford Ivar Nassは、先述したClippyを人に愛されるように改善しました。Clippyが「これはあなたの役に立ちましたか?」と聞いたときにユーザーから否定的な答えが返ってきたら、「私も悲しい。これはプログラムが良くないので、MSに言っておきます。」というような共感を表すようにしました。この改善によって、Clippyは好まれるようになったのです。

感情を察知し、寄り添うことも重要

感情はとても大事です。それが分かる事例があります。あるIQの高い人が脳腫瘍をして前頭葉を損傷し、合理的な思考を司る皮質と感情を司る辺縁系が機能しなくなってしまいました。それにより、その人は、何をしても、何を考えても感情が伴わず、決断が出来なくなったのです。計画や意思決定には、感情が必要である証拠です。

特に、コールセンターでは、これが顕著に現れます。システマチックに問題を解決したり情報提供をするよりも、ユーザに寄り添い共感を表すサポータが感謝され、ユーザは満足します。

シンプルな質問には、大きく4つのメッセージ(意味)が含まれています。

- 基本的な情報が欲しい

- よくわからないのでとにかく助けてほしい

- 別の問題がある

- 自分のことを考えて欲しい

これらのうち、どのメッセージなのかによって、対応方法は変わってきます。しかし、どのメッセージを発しているのかを、15秒で見極めなくてはなりません。(メッセージの)影に隠れている感情を察知することが必要なのです。

Jacobs DH氏らは、1995年に6つの基本的かつ普遍的な感情を定義しました。

Jacobs DH氏らが定義した6つの基本的かつ普遍的な感情(1995年)

これは、感情を検知するアルゴリズムに応用されています。話しかけた時の声のトーンから感情を推測するというようなアプリケーションなど使われてます。

このアプリケーションを用いたボットを使って、理学療法士が治療するとします。すると、ある人に対しては強い感じで鼓舞したり、内向的な人には優しい言い方にする、という風に患者の性格に合わせて、ロボットがパーソナリティを変えることが出来ます。

機械とのインタラクションは情報のやりとりと捉えがちですが、それだけではありません。感情的、社会的な問題に対処しない(それらを無視する)と上手くいかないものです。

コールセンターで作業を合理化するために、会話を短く効率的に終わらせようとして失敗したことがありました。なぜなら、不満を持って電話してくる人は「聞いて欲しい」という欲求がありからです。

話を聞いて、「その次は何をしたいか?」を聞き返す丁寧な対応で、ユーザーから感謝されることもあります。そのような対応だと、満足させるためにクーポンを出したりする必要もないし、訴訟になることも少なかったです。

ユーザーに共感し、感情を持って話しかけることで、記憶に残る心地の良い体験を提供することが出来るのです。