この記事は、UX DAYS TOKYO 2017で開催されたケニー・ボールズ(Cennydd Bowles)氏の講演レポートです。AI(artificial intelligence、人工知能)と倫理をテーマにUXデザイナーが何を考えるべきかをご紹介いただきました。

ユーザの信頼を獲得する

最も危険な誤解は技術が中立的なものであると考えてしまうことです。技術と人が共に行動することで、新しいことができるようになります。そして、私達が作るもの全てが道徳的に正しいものでもなく、間違っているものでもありません。

例えば、以下のようなものが上げられます。

- MicrosoftのTay(AI)が人種差別的な発言を繰り返した

- Facebookがユーザの同意なしにタイムラインをコントロールし、感情(印象)操作の実験を行った

- Uberが障害者法に従わなかった

- Snapchatのアプリの一部機能が少数の民族に対して差別的であった

こういった例にある技術はユーザの信頼を失いつつあります。これからの10年でIT業界はユーザーの信頼を回復しなければならないでしょう。なぜなら、ITの発達により人々の生活により密接なものとなるからです。

信頼を獲得するためには、「技術は中立である」という偏見を捨てなければなりません。技術の責任を通して「倫理」をどう作っていくかを考え抜く必要があります。この課題の良い例として、望ましくない結果が出ないようにデザインされているものがあります。

大きな音が出て聴力に障害となってしまわないように音量調整するスピーカー |

道路の減速帯 |

これらのデザインされたものは今後私たちが「どうなるべきか」「どうならないべきか」という方向性を明確にすることで生まれます。

AIダークパターン(Dark Pattern)

ダークパターンとは、意図的にユーザを騙すようなデザインのことです。例えば、購読停止の機能を背景色と同じテキストで記述して見えないようにするデザインはダークパターンに該当します。このデザインにより解約を抑制しています。

ダークパターンは多くのデザイナーが出くわす問題です。会社の指示でダークパターンのデザインが指示された時、どのように対処するかでデザイナーにとっての「倫理」が問われます。

購読停止の機能を背景と同じ色にしてわかりにくくしている

プライバシー保護

アメリカ政府は、プロバイダがユーザーの閲覧履歴を販売することを許可しました。これを「監視資本主義」と名付けて倫理的でないと批判する人もいますが、この批判は少し大げさです。

なぜなら、この規制緩和により無料で利用できるデジタルプロダクトがたくさんあり、結果としてユーザの利益に繋がるからです。

このように、ユーザーのデータは価値あるものですが、一方で有害となりうる時もあります。サービス提供者はどういった情報を集めているのか、一方でユーザーは何を放棄し、また与えてくれているのかを報告し、その情報を保護することが必要なのです。

倫理について

私たちは日々ユーザーを説得しユーザーの行動を変えています。「禁煙」「貯金」「安全な食事」等、ユーザーにとって良いこと、安全なものであれば説得することは簡単です。

これらを促すということは当然商業的にも利用されます。しかし、「ユーザにとって良いこと」というのは誰が判断するのでしょうか?また、その判断基準が不変である保証もありません。

デザインと信頼性

過去、信頼性の高い情報は高いデザイン性を持っていました。現在では、デザインを簡単に流用できるので質の悪い情報や嘘までもが高いデザイン性を伴うようになっています。

フェイクニュースなど嘘の情報かどうかを判断するのは難しくなり、多くの人は自分の思想や・考えに沿っているものであれば簡単に信じてしまいます。嘘の情報が広がった際、人々を正しい方向に導くためにどのような役割を担うべきかをデザイナーは考える必要があります。

AIによる偏見

AIは例えばチェスや囲碁などのゲーム、干ばつの予測などにおいて、既に人間の能力をはるかに超えています。

数年経てば金融政策などの領域で、AIは人間より長けた判断を出来るようになり、人間が問題だと認識していなかったような問題も解決出来るかもしれません。

GoogleのDeepMindなどのような汎用性の高いAIが安価で商品化され、普及されていくと倫理的な問題が出てくるようになります。これは1980年代から指摘されていた問題です。例えば、刑務所内の黒人の再犯率の予測値を高く見積もるなどのように、AIによる偏見が観察されています。

AIの偏見の原因は「学習用のデータ」「アルゴリズム」の2つが考えられます。上述のMicrosoftのTay(AI)はその両方によりバイアスがかけられた状態でした。私たちにはその偏見を確認、周知し、問題を解決する義務があります。

トロッコ問題に代表される倫理のゆらぎ

AIや機械学習のアルゴリズムはブラックボックス化しやすく、新しい技術と倫理の境目を見定めるのが難しいです。

デザイナーは複雑性を隠し直感的なデザインを目指しますが、それはリスクでもあります。IoTの時代で膨大なデータが収集、加工されて最終的なアウトプットだけがユーザに見える形になると、内部で何が起こってるか分からず倫理的な行動が出来なくなってしまいます。

物理的なデバイス(例えば自動運転車)ではそれが顕著で、トロッコ問題と呼ばれる有名な思考実験があります。

トロッコ問題の図

この問題では、全員が助かる選択肢はなく、誰の命を優先すべき(つまり誰を殺すのか)の選択が迫られます。これはつまり命の価値を測るということです。このような状況に出くわした場合、自動走行車はどのようにデザインされるべきでしょうか?様々な考えがあり、今でも議論が行われています。

例えば、メルセデスはどんな場面でも運転手の安全を優先する、という方向性を打ち出しています。「自動走行車を購入する人は、既に歩行者よりも自分自身を守ることを選んでいるのと同じである」という指摘が有力視され、メルセデスの方向性は多くの人に支持されています。

また、このトロッコ問題は保険のあり方にも影響します。自動運転の行動に対し、責任の所在、説明はどこにすべきか等の議論が進んでいます。これら問題は、運転の自動化レベル(Level0〜5)と併せて議論する必要があります。

| ※運転の自動化レベル…各政府は自動運転の技術に対し6レベルに分けて分類整理している。 レベル0が現在の通常の自動車(非自動運転)を指し、レベル5がすべての操縦をシステムが担う状態を指す。 |

ユーザーはどこまでが自動コントロールの範囲で、どこまでが範囲外なのかを把握する必要があります。例えば、テスラのオートパイロット(自動運転)機能はおそらくLevel3程度(実際には1、2に近い)であり、名前はマーケティング的に考えられていますが、それは安全性を保証しているものではありません。ユーザは感覚に踊らされずにその責任と安全の所在を見極める必要があります。

UIと倫理

昨年(2016年)月にダラスの警察遠隔制御ロボットがC4爆弾を持っている犯人を殺害した事件がありました。

| ※C4:テロなどで使われることのあるプラスチック爆弾

(警察が)リモートコントロールされているロボットなので法的に言えば問題はない。 |

では、ロボットではなくて警官が直接対応したらどうだったのでしょうか?

人間が対応していたら、恐らく犯人を殺すまではしなかったでしょう。ロボットを操作していたオペレーターは遠隔であったため、コンテクストとしての意味合いが薄れ、殺害の躊躇がなかったのではないかと言われています。

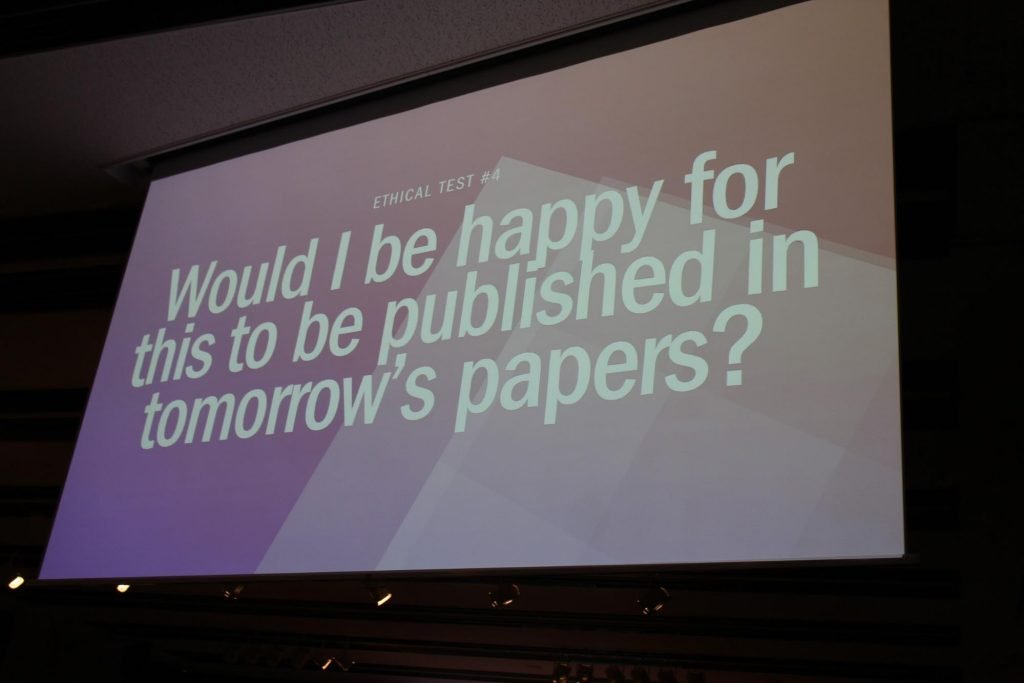

倫理テスト

デザインが倫理的であるかどうか判断するには、以下の4つの質問について考えてみてください。

(倫理テスト1)私がしようとしている事と同じ事を皆がしたら、より良い世界になるか?《普遍化》

(倫理テスト2) ユーザーを目標として扱っているのか、もしくは手段として扱っているか?

(倫理テスト3)多くの人の幸福の最大化貢献しているか? 《幸福の最大化》

(倫理テスト4) 明日の新聞にこれが出たら自分は嬉しいか? 《美徳》

組織に対しNOと言うために

大きな組織の中で「倫理」を理由とし、デザイナーが指示に対してNOと言うことは難しいことかもしれません。その場合は違う手段を考えてみてください。

その手段とは、デザインプロセスを新しくすることで見えてきます。ビジネスのアプローチとしては以下の3つがあります。

- 売り上げの向上

- コスト削減

- リスクを削減

この3つに分解して代替案を提案することが効果的です。

文化・環境と倫理

組織(会社・チーム)のリーダーの言動が環境を作っていきます。新しい環境に移ることを考えているデザイナーにとっては、組織の風土をまずはよく知ってから入ることをおすすめします。

なぜなら、その風土を自分が真似することになるかもしれないからです。そして、倫理を守るためデザイナーであるためには、以下の2つに注意していく必要があります。

- 日々行動しなければならない

- チェックリスト(倫理項目をチェックすることが目的)になってしまってはいけない

まとめ

デザイナーは倫理を考えることが、結果的にユーザーに与える影響を日常の仕事の中で考え、行動しなければなりません。その過程には難しく複雑で、時には気まずいこともあるかもしれません。しかし、技術が信頼を得るためには倫理を十分に考えることが必要なのです。