―― 2026年1月14日(水)UX勉強会レポート(参加者5名)

「AIがあれば、もっと正確にユーザーがわかるはず」「ペルソナを作れば、顧客理解はできている」

そんな“分かったつもり”が、実はプロダクトを静かに壊しているかもしれない――。

今回のUX勉強会では、「想像上のユーザー」と「感情認識AI」という二つのテーマを通して、**“正しく考えないまま使われる手段の危うさ”**について深く議論しました。

手段が悪いのではなく、「使い方」が危険になる

勉強会を通じて浮かび上がった最大の共通認識は、次の一言に集約されます。

問題なのはツールではなく、その“使い方”である。

ペルソナも、AIも、UXのフレームワークも、本来はユーザーを理解するための「手段」にすぎません。

しかし、そこに“考えることをやめる”瞬間が訪れると、ツールは一気に「仕事化」し、形骸化し、やがて危険な存在へと変わっていきます。

① 想像上のユーザーのためにプロダクトを作っていないか?

Stop building products for your imaginary users

最初のテーマは、「ペルソナが、かえって製品開発の足を引っ張る最大の重りになることがある」という記事。

この記事は一見すると「ペルソナは悪だ」と受け取られがちですが、今回の参加者全員が、ペルソナ自体を否定するのではなく、“正しい使い方”を考えることが重要だという結論に至りました。

議論の中で繰り返し出てきたのは、こんな言葉です。

- ペルソナは“作ること”が目的ではない

- ユーザー理解の代替物にしてはいけない

- 生身のユーザーの声・行動・迷い・選択を見なくなった瞬間、ペルソナは危険になる

ペルソナは、本来ユーザー理解を助けるための仮のモデルであるはずが、いつの間にか「それ自体が正解」になり、

“実在しない誰かのために、実在しない課題を解く”プロダクト開発が始まってしまう。

参加者からは

「ペルソナを作る作業に時間を使いすぎて、ユーザーに会う時間がなくなっている現場も多い」

という声も上がりました。

本当に重要なのは、ペルソナではなく、目の前の“生きているユーザー”の声と行動なのだと、改めて確認する時間となりました。

② AIは感情を読めるのか? そして、読ませていいのか?

The UX of emotion recognition: Can AI truly read feelings?

二つ目のテーマは、感情認識AIの技術的・倫理的リスク。

市場規模20兆円とも言われるこの分野は、「表情=感情」という前提のもとに急速に発展しています。しかし記事では、その科学的な土台自体が揺らいでいることが指摘されていました。

勉強会では、

- 感情は顔の表情だけで決められるほど単純ではない

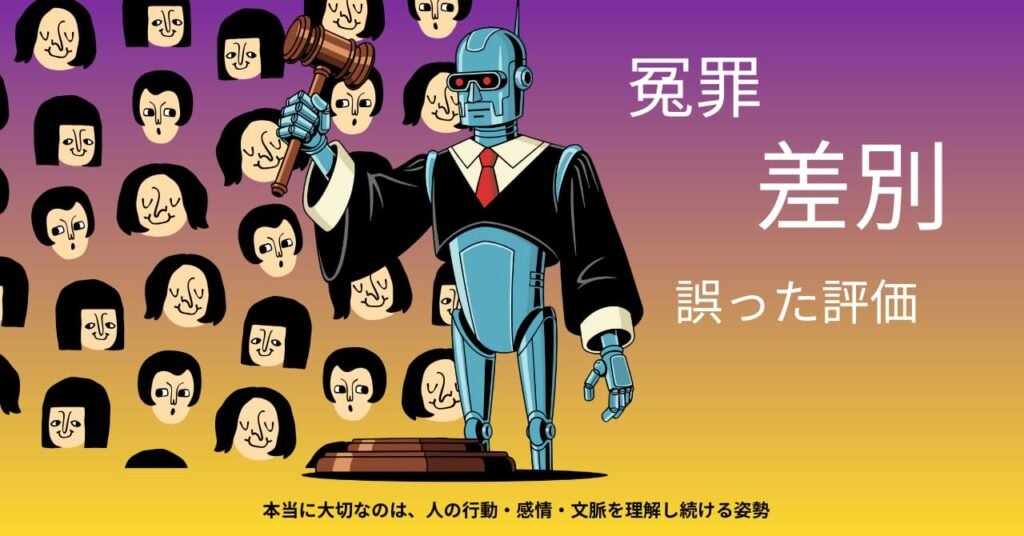

- AIによる“正確そうな判断”が、かえって冤罪や差別、誤った評価を生む可能性

- AIの言葉ですら人の意思決定を大きく左右してしまう現実

といった点が議論されました。

特に印象的だったのは、

人は「AIがそう言うなら正しいのでは」と、簡単に思考を預けてしまう

という指摘です。

米国では、AIとのやり取りがきっかけで自殺に追い込まれたとされる事例もあり、

“感情を扱うAI”は、便利さと同時に極めて強い影響力を持つことが共有されました。

人の感情を扱うプロダクトは、今後ますます増えていくでしょう。

しかし同時に、「そのプロダクトは誰のためのものか」「どんな危険をはらんでいるのか」を、UXの視点から問い続ける必要性も、これまで以上に高まっていると感じさせられました。

AIは魔法ではない。だからこそ、UXが問われる

今回の勉強会を通して、参加者全員が強く実感したのは、

- AIは“答えをくれる魔法”ではない

- ペルソナは“考えなくていい免罪符”ではない

- 本当に大切なのは、人の行動・感情・文脈を理解し続ける姿勢

ということでした。

プロダクト開発が効率化され、ツールが高度になるほど、

「ちゃんと考えること」「ユーザーを見ること」「疑問を持つこと」は、後回しにされがちになります。

だからこそ、これからの時代は、UXを“もっとちゃんと学ぶ”ことが、これまで以上に重要になる。

そんな共通認識で、この勉強会は締めくくられました。

“便利そうだから”“流行っているから”ではなく、

「それは本当に人のためになっているのか?」と問い続けられるかどうか。

その問いを持ち続けること自体が、これからのUXの本質なのかもしれません。